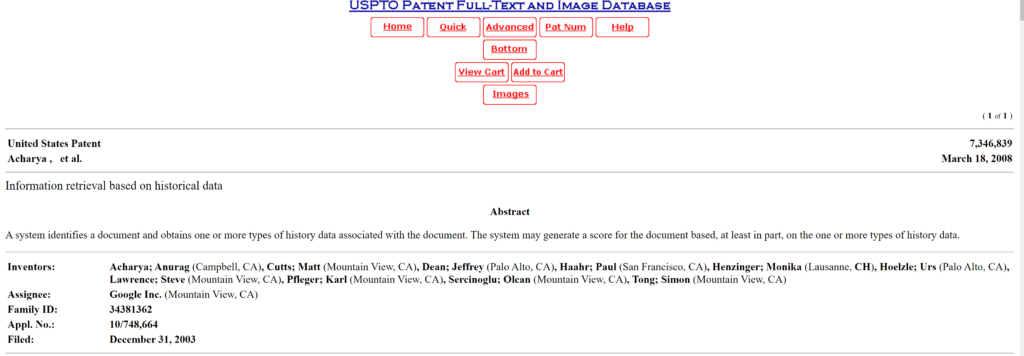

Google, brevetto sui dati storici

Information retrieval based on historical data I Dati Storici rappresentano tutti quei dati relativi ad analisi di tipo storico che i motori di ricerca possono analizzare per attribuire al sito la posizione più indicata tra i risultati delle ricerche: dall’anzianità del dominio alla variabilità nel trend degli aggiornamenti. Questo “sistema di valorizzazione” consiste nell’ esaminare diversi aspetti nell’ archiviazione …